[smartPC사랑=이백현 기자] 최초의 그래픽카드는 메모리에 표현된 고정된 이미지를 디스플레이로 옮기는 단순한 작업을 위해 만들어졌다. 그러나 어느덧 그래픽카드는 3D 이미지를 실시간으로 화면에 표시해주기 위해 각종 계산기능을 하드웨어에 내장하더니, 지금에 와서는 AI 산업의 ‘심장’으로 불린다. 머신러닝용 그래픽카드를 생산하는 엔비디아는 근래 주가가 폭등해 ‘1조 클럽’에 진입하기도 했는데, 과연 그래픽카드, 특히 GPU는 AI 산업에 어떤 역할을 하길래 이렇게 ‘몸값’이 뛰는 걸까?

AI 산업의 핵심은 딥 러닝

그래픽카드는 오늘날 전 세계의 수많은 컴퓨터에서 그래픽 연산의 역할을 주도하고 있다. 게임, 멀티미디어 콘텐츠, 3D 모델링과 같은 그래픽 작업을 처리하는데 그래픽카드는 필수적인 요소다. 그러나 최근 몇 년 동안, 그래픽카드의 역할은 그래픽 처리뿐만 아니라 인공 지능 (AI) 연구의 핵심 요소로 발전했다.

인공 지능, 특히 딥 러닝은 머신러닝의 한 분야다. 딥 러닝은 심층 신경망을 활용하여 이미지 인식, 음성 인식, 텍스트 생성 등 다양한 작업에서 인간 수준의 성능을 보이고 있다. 바둑 기사 이세돌을 상대로 대국에서 승리해 주목받았던 ‘알파고’나, 최근 주목받고 있는 ChatGPT 등 생성형 AI 모델도 크게 분류하면 이 딥 러닝의 결과물이다.

딥 러닝, 단순 연산 반복 필요

이 딥 러닝에 필요한 연산의 특징은, 비교적 단순한 계산을 아주 많이 실행해야 한다는 것이다. 인간으로 따지면 ‘9 곱하기 8’ 정도의 문제를 수천 번, 수만 번 필요로 하는 것과 마찬가지다. 따라서 복잡한 연산을 빠르게 수행하기 위해 만들어진 중앙 처리 장치, CPU만으로는 이를 효과적으로 수행하기 어렵다. CPU는 단순하면서 많은 계산보다는 복잡하고 정교한 계산을 수행하는 데 더 작합한 하드웨어이기 때문이다.

병렬 계산에 특화된 장치, GPU

이러한 문제를 해결하기 위해 개발자들은 그래픽카드 내부의 연산 장치, GPU에 주목하게 됐다. 십 수개의 연산 코어를 가지고 복잡한 연산을 수행하는 CPU와 달리, GPU는 수천에서 수만 개의 연산 코어를 갖고 있기 때문이다. 각각의 코어는 복잡한 계산을 수행할 능력은 갖추지 못했지만, 대신 숫자가 많기 때문에 여러 개의 계산을 동시에 처리할 수 있다.

즉, GPU는 단순 계산의 병렬 처리에 매우 효과적인 구조를 가지고 있다. 컴퓨터 게임에서 우리가 보는 화면의 점, 즉 픽셀은 그 각각이 계산의 결과물이다. GPU는 이 ‘픽셀의 점’이라는 단순한 계산을 한 번에 수십 만개씩 동시에 처리할 수 있는 능력을 갖추고 있는데, 수십 만개의 계산을 초당 몇 번(동시에) 처리했는지가 바로 주사율, 프레임레이트가 되는 셈이다.

그래픽 연산 말고 다른 연산도 해! GPGPU

그럼 GPU에게 그래픽 연산 말고 조금 더 일반적인 연산을 시킬 수 없을까? 이런 발상으로 탄생한 기술이 바로 GPGPU이다. GPGPU는 General-Purpose computing on GPU의 약자로, ‘GPU의 범용 연산’을 뜻한다. 바로 이 기술이 딥 러닝의 핵심이 되는 셈이다.

그런데 GPU는 원래 그래픽 연산을 위한 장치이기 때문에 하드웨어만으로는 그래픽 외의 다른 연산에 사용할 수 없다. 원하는 연산을 GPU에게 시키려면 별도의 소프트웨어적 기반이 필요한데, 이 기반을 제공하는 플랫폼이 바로 엔비디아에서는 CUDA, 그리고 AMD의 ROCm인 셈이다.

CUDA는 왜 생태계를 지배하게 되었을까?

특히 CUDA은 엔비디아 CUDA 코어가 장착된 GPU가 범용 연산을 수행할 수 있도록 만들어주는 플랫폼이다. 이는 이름에서 알 수 있듯 CUDA 코어가 달린 엔비디아 GPU에서만 작동해서, 사실상 엔비디아가 AI 생태계를 장악할 수 있는 원동력이 되었다.

AI 생태계를 독점 플랫폼으로 장악하고 있다고 해서 엔비디아를 비난할 수는 없다. 엔비디아는 CUDA 플랫폼을 AI 산업이 본격화하기 훨씬 이전인 2007년에 최초 출시했으며 이 ‘병렬 컴퓨팅’이 미래에 유용할 것이라 생각하고 역량을 쏟았기 때문이다. 먼저 이 CUDA 생태계에 투자했기 때문에 업계 개발자들이 빠르게 유입됐고, 선점 효과를 누리고 있는 것이다. CUDA는 엔비디아 CUDA코어에서만 동작하지만 개발자들은 이미 충분한 토양이 마련된 개발 환경에서 벗어날 이유가 굳이 없다. AMD의 ROCm 플랫폼이 아직 활성화되지 않은 이유다.

향후 전망은?

GPGPU가 AI의 핵심이 된 이상 GPU의 미래 전망도 당분간은 밝다. 특히 이미 양산되고 있는 하드웨어가 있는 만큼 근시일 내로 AI 시장에서 GPU가 역할을 잃을 일은 없을 것이다.

한편 지금의 GPU는 어디까지나 픽셀 단위 그래픽 작업 특화를 위해 설계됐다, 기존의 하드웨어를 AI용으로 ‘용도 변경’한 게 지금의 GPGPU이므로, AI를 위해 최적화된 하드웨어는 아닌 셈이다.

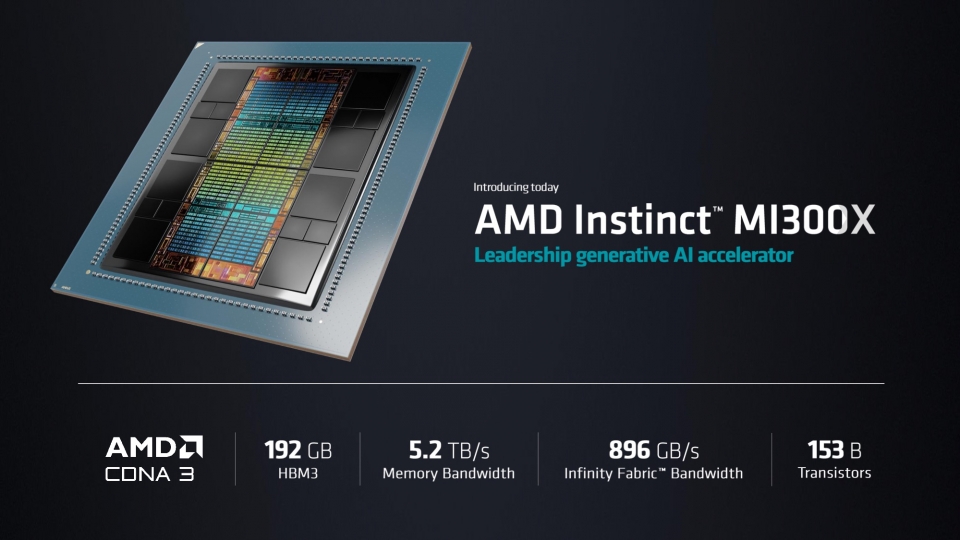

구글, 아마존, 메타와 같은 기업들은 이미 AI 전용칩에 뛰어들어 ‘칩 자립화’를 이루려는 시도를 하고 있다. 엔비디아, AMD 등 기존 GPU 제조사가 이를 어떻게 대응하느냐에 따라 미래 AI 하드웨어 시장에 변화가 생길 것으로 보인다.